Cách chọn chỉ số Data Drift trong ML Production

Cách chọn chỉ số Data Drift trong ML Production

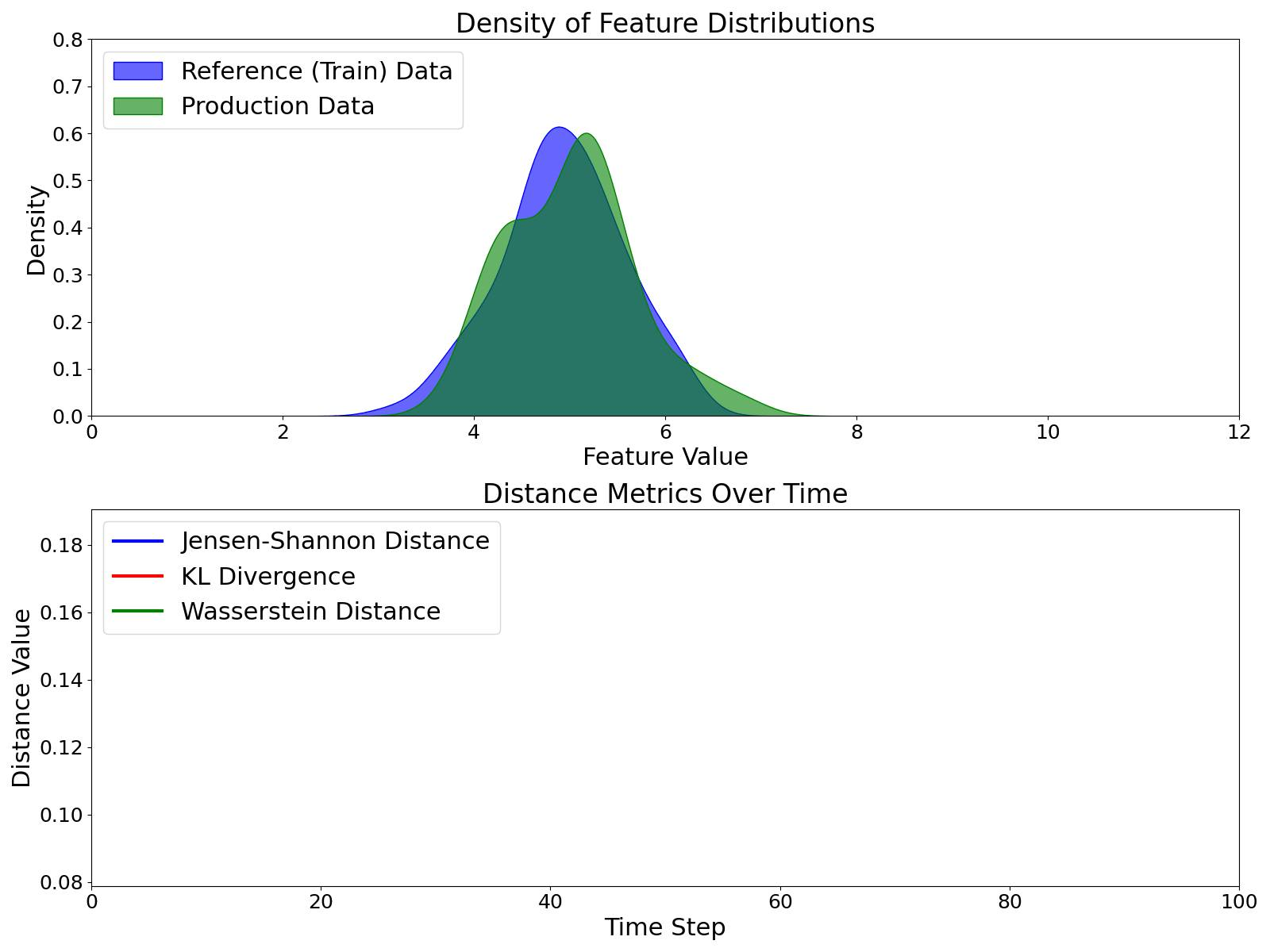

(So sánh KL Divergence, Wasserstein Distance, và JS Distance)

(So sánh KL Divergence, Wasserstein Distance, và JS Distance)

Ưu điểm:

-

Đối xứng & dễ hiểu: Khác KL, JS đối xứng và luôn nằm trong [0,1] → dễ đặt ngưỡng.

-

Ổn định theo thời gian: Khi 2 phân phối gần như không trùng, giá trị bão hòa → hạn chế báo động giả.

-

Chống nhiễu: Ít bị ảnh hưởng bởi outlier nhỏ → phù hợp cho giám sát ổn định.

Nhược điểm:

-

Tốn tính toán: Nặng hơn khi dữ liệu nhiều chiều.

Ưu điểm:

-

Nhạy với thay đổi nhỏ: Phát hiện sớm drift nhẹ → phù hợp cho hệ thống cần cảnh báo nhanh.

Nhược điểm:

-

Dễ bất ổn: Nhạy với outlier → dễ sinh báo động giả trong dữ liệu thực tế.

Ưu điểm:

-

Ổn định: Xử lý cả thay đổi lớn mà không “nhảy spike” bất thường.

-

Không phụ thuộc vào trùng lặp phân phối: Vẫn tính được khi 2 tập dữ liệu không có giao nhau.

Nhược điểm:

-

Tốn tài nguyên: Khó tối ưu cho tập dữ liệu lớn hoặc yêu cầu real-time.

-

JS Distance → Khi cần dễ hiểu, đặt ngưỡng ổn định.

-

KL Divergence → Khi cần nhạy, phát hiện sớm drift nhỏ.

-

Wasserstein Distance → Khi cần theo dõi mượt, ổn định trước thay đổi lớn.

No Comments